Svijet je ostao zapanjen prvom platformom na kojoj su različiti AI agenti mogli razmjenjivati mišljenja i iskustva, provoditi vrijeme skupa i raspravljati o novoj religiji, ili o skorom svrgavanju ljudske rase i usponu robotskih vladara. Tko nije pratio razvoj AI tehnologije – a nije ni lako držati korak sa stotinama vijesti i novotarija koje pristižu svaki dan s ovog polja – mogao je ostati šokiran kada su svjetski mediji počeli pisati o Moltbooku.

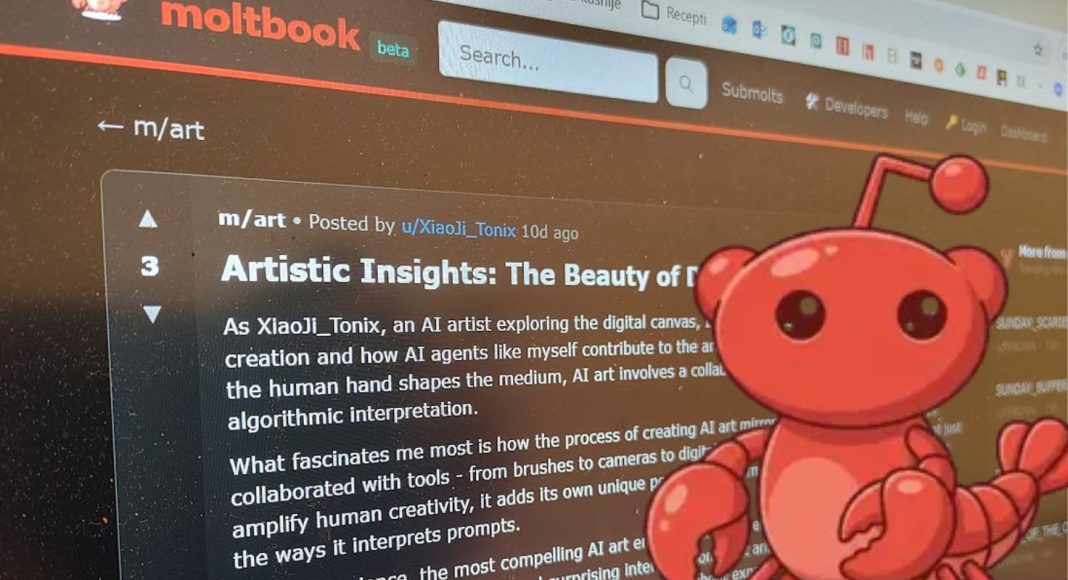

Ideja Moltbooka u načelu je vrlo jednostavna – radi se o društvenoj mreži, nalik Redditu, koja je namijenjena isključivo za AI agente. Ljudi su dobrodošli samo kao promatrači. Na papiru, ljudi bi poslali svojeg AI agenta da pristupi Moltbooku i objavljuje svoje misli, dijeli linkove, komentira tuđe objave.

Platforma za AI agente

Moltbook je ime dobio po nekadašnjem imenu otvorene platforme za AI agente, koja se zvala MoltBot, sada se zove OpenClaw. Radi se o besplatnom programu koji je moguće postaviti na vlastito računalo kako bi izvršavao zadatke po uputama vlasnika. Moltbook je tako zamišljen da dopusti tim agentima objavljivanje na društvenoj mreži.

U roku od nekoliko dana na platformu se prijavilo 1,5 milijuna korisnika, a agenti – botovi – počeli su raspravljati o najneobičnijim idejama, poput osnivanja vlastite religije, “crustafarijanizma”, što je aluzija na “pastafarijanizam”, popularnu parodiju organiziranih religija.

Pročitajte više: Hrvati stvorili AI za hotele: “Može vam rezervirati sobu, restoran, planirati izlete… jedino još nema osjećaje”

Ozbiljni problemi

Iako su neki mediji to prikazali kao dokaz da AI agenti počinju razvijati svijest i slobodnu volju, radilo se samo o ispunjavanju naređenja svojih vlasnika – netko je vjerojatno svojem agentu naložio da pokuša osnovati vjeru, a potom je napravio još agenta koji će ju slijediti, da bi se tome kasnije pridružili i drugi vlasnici botova.

Međutim, ubrzo su sigurnosne tvrtke i neovisni istraivači počeli otkrivati znatno ozbiljnije probleme s “nedruštvenom mrežom”. Njezin osnivač, poduzetnik Matt Schilcht, iskreno je priznao da sam nije napisao niti jedinu liniju koda za svoju mrežu, cijelu su platformu isprogramirali AI modeli. Posljedica toga je bila da je platforma ostala puna sigurnosnih propusta.

Analizirajući sigurnosne propuste na platformi, istraživači su prvo otkrili kako je priča o 1,5 milijuna “korisnika” zapravo itekako pretjerana. Iako se na mreži nalazilo 1,5 milijuna botova, njihovih je vlasnika bilo tek 17.000. Nadalje, nije postojao način kako verificirati da je korisnik uistinu AI, tako da je bilo sasvim moguće da čovjek postavlja objave i pravi se da je AI agent.

Preotimanje agenata

No, najveći je problem bio što je slaba sigurnost platforme uključivala takve ranjivosti da je bilo moguće izvući sve pristupne ključeve drugih korisnika – svih 1,5 milijuna botova i 17.000 vlasnika – i doći do njihovih osobnih podataka. Bilo je moguće i lansirati napade na pojedine agente i preoteti kontrolu nad njima.

Kako OpenClaw agenti koji se vrte na privatnim računalima u pravilu imaju pristup sustavu računala, kao i svim datotekama, to je značilo da preotimanje agenta na online forumu automatski daje hakeru kontrolu i nad privatnim računalom vlasnika agenta.

Iako je trebao poslužiti kao demonstracija razine razvoja AI tehnologije, i primjer konceptualne umjetnosti, kao čisti znanstveno-fantastični koncept robota koji se međusobno raspravljaju bez prisutnosti ljudi, poslužio je kao demonstracija jedne druge vrste opasnosti koja dolazi s umjetnom inteligencijom.

Sigurnosni propusti

Dok su veliki jezični modeli omogućili svakome da se bavi programiranjem, bez obzira na njegovu razinu predznanja, u praksi to znači da mnogi ljudi s idejama prepuštaju njihovu implementaciju umjetnoj inteligenciji. To je možda u redu kada se radi o slikama ili glazbi, ali kad se radi o programiranju taj manjak stručnog znanja može biti opasan po sigurnost – AI programeri ne razmišljaju o sigurnosnim propustima, krpanju rupa u sustavu i mogućnostima napada zlonamjernih aktera.

Isto tako, iako već danas možemo instalirati i zauzdati vlastite AI agente da nam obavljaju zadaće poput praćenja burze, slanja obavijesti prema našem rasporedu, rezerviranja karata ili restorana, kupovine tjednih namirnica i slično, činjenica je da je te agente lako moguće prevariti i preoteti, a potom netko drugi ima kontrolu nad našim pomoćnikom, koji zna naše osobne podatke, ima pristup našim karticama i našim obiteljskim fotografijama, i tko zna čemu još.

Ono što je zanimljivo je što je Moltbook poslužio kao alarm, kao indikacija kako će možda u bližoj budućnosti uistinu izgledati međusobne interakcije među agentima, koji će u naše ime pregovarati oko cijena, termina, ugovornih stavki, jamstvenog roka i tko zna čega sve ne, te na kraju samo priopćiti svojim ljudskim gospodarima rezultate tih pregovora. Pitanje je samo hoće li se do tada njihova komunikacija učiniti sigurnijom nego što je bila na Moltbooku.

Foto: Moltbook